Главная страница Случайная лекция

Мы поможем в написании ваших работ!

Порталы:

БиологияВойнаГеографияИнформатикаИскусствоИсторияКультураЛингвистикаМатематикаМедицинаОхрана трудаПолитикаПравоПсихологияРелигияТехникаФизикаФилософияЭкономика

Мы поможем в написании ваших работ!

Энтропия источника

Энтропия дискретного источника – это среднее количество информации, содержащейся в одном сообщении, т.е. при основании кода a=2:

Энтропия зависит от количества событий и их вероятностей Pi;

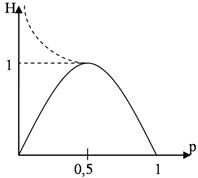

Зависимость H=f(Р)

|

Рис. 1.2. График зависимости H от p

Можно показать, что если N>2, то при увеличении N точка максимума будет смещаться влево и возрастать (на графике это показано штрихпунктирной линией). Nmax будет при равновероятных событиях.

| <== предыдущая страница | | | следующая страница ==> |

| Свойства операций над строками | | | Энтропия сложного события |

Дата добавления: 2014-03-11; просмотров: 452; Нарушение авторских прав

Мы поможем в написании ваших работ!